背景

Deepseek-r1开源模型目前为中国出的全球最强的开源模型,当前deepseek账户量已达1亿,ds公司的卡资源不足,关闭了api申请并且网页访问时不时的出现“服务器繁忙,请稍后再试。”,体验比较差。

当前在2025年2月11日,在网上搜索了一圈,发现腾讯云提供了满血版Deepseek-r1模型免费使用,并且可免费使用到2月25号,而且还提供了api接入,这对我这种使用api的人是大大的利好。

使用

腾讯云把Deepseek-r1/v3模型部署在了知识引擎中,使用之前需要注册腾讯云账户。当然文档也写了快速接入方式。

快速接入

- 直接访问知识引擎控制台,注册账号,并实名认证。

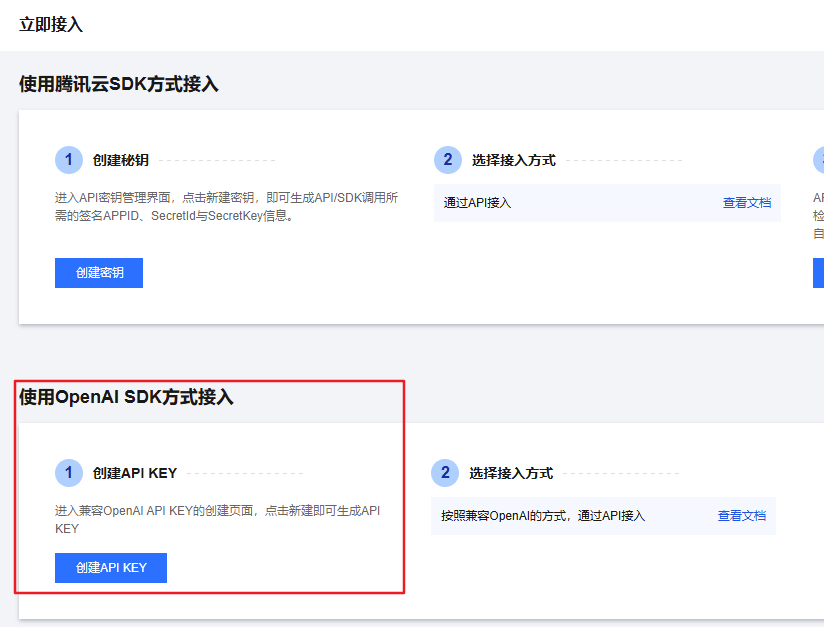

- 开通openai兼容模式的api key

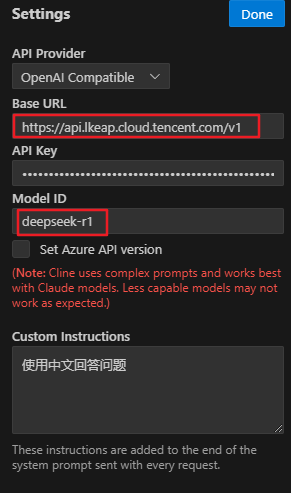

- 拿到sk-xxx这个apikey之后,就可以到cline等插件中配置模型了,也可以把模型配到lobechat中去,然后就可以愉快地使用了。

其中api提供者选择openai兼容接口,apikey就是腾讯云给的key,Base URL填写:https://api.lkeap.cloud.tencent.com/v1,ModelID填写deepseek-r1,这样就搞定了。

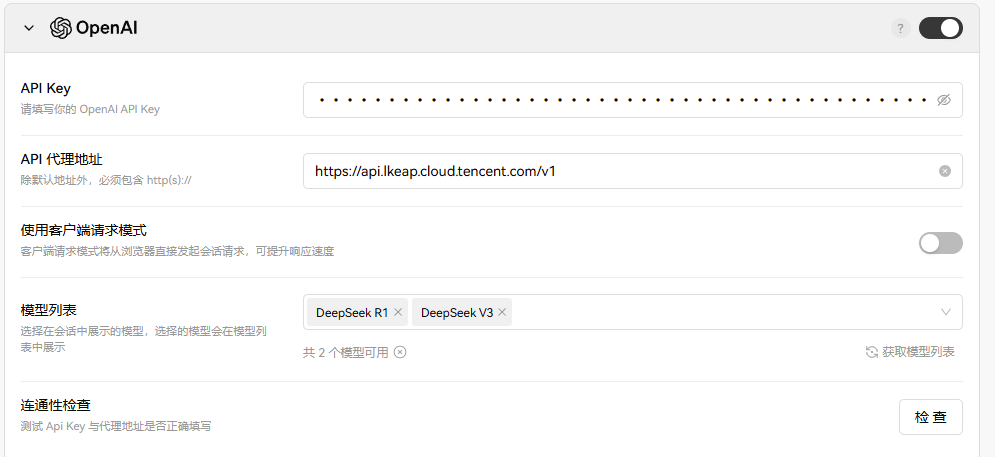

lobechat中的配置,仅供参考

效果

妈妈再也不为我那服务器繁忙担忧了。